Wie Sie erfolgreich Data Science Projekte im QM meistern25 | 03 | 21

Das weltweite Datenvolumen soll bis 2025 auf 175 Zettabyte wachsen, so die International Data Corporation (IDC) – eine unvorstellbar große Zahl mit 21 Nullen. Unternehmen sind für einen Großteil dieser Bytes verantwortlich und verfügen damit über immer mehr Daten, die grundsätzlich zur Analyse zur Verfügung stehen. Das trifft insbesondere auch auf das Qualitätsmanagement zu: So liegen heute neben immer mehr Maschinendaten auch nutzungsspezifische Informationen zu jedem produzierten Produkt vor. Um dieser zunehmenden Menge und Bandbreite an verfügbaren Daten Herr zu werden und diese mehrwertstiftend für das Qualitätsmanagement zu nutzen, ist eine maschinelle Unterstützung der Mitarbeiter bei der Datenanalyse zwingend erforderlich. Vor diesem Hintergrund wird Data Science und der Einsatz neuer Technologien wie Künstliche Intelligenz immer wichtiger. Mit folgendem Artikel möchten wir Ihnen zeigen was Data Science Projekte so besonders macht und wie ein typisches Data Science Projekt abläuft. So können Sie Ihr Unternehmen optimal vorbereiten und Ihre Data Science Initiativen zum Erfolg führen.

Was sind typische Data Science Use Cases fürs Qualitätsmanagement?

Data Science und Künstliche Intelligenz (KI) sind mittlerweile in vielen Funktionsbereichen und Branchen Thema, so auch im Qualitätsmanagement. Der Studie „Deutscher Industrie 4.0 Index 2019“ der Staufen AG und der Staufen Digital Neonex GmbH zufolge steht die Nutzung und Auswertung von Big Data im Qualitätsmanagement an erster Stelle, gefolgt von der Produktenwicklung. Doch wie sehen konkrete Fragestellungen und Anwendungsfälle im Bereich QM aus?

Zu den typischen Anwendungsfällen im Bereich des Qualitätsmanagements gehören z. B.:

- Predictive Quality: Prognose der Qualität Ihrer produzierten Teile und Ursachen-Analyse von Fehlerquellen für ein vorausschauendes Qualitätsmanagement und die Reduzierung von Ausschuss

- Zentrale Analyse von Produkt- und Servicedaten: Auswertung von u. a. Kundenkommunikation, Produkt-, Produktions- und Qualitätsdaten für eine 360° Sicht auf Produkt- und Servicequalität zur Steigerung der Kundenzufriedenheit und Senkung der Qualitätskosten

- Lieferantenbewertung: Entwicklung eines Bewertungssystems zur vergleichbaren und systematischen Leistungsbeurteilung von Lieferanten zur Verbesserung der Beschaffungsqualität

Wie läuft ein Data Science Projekt ab?

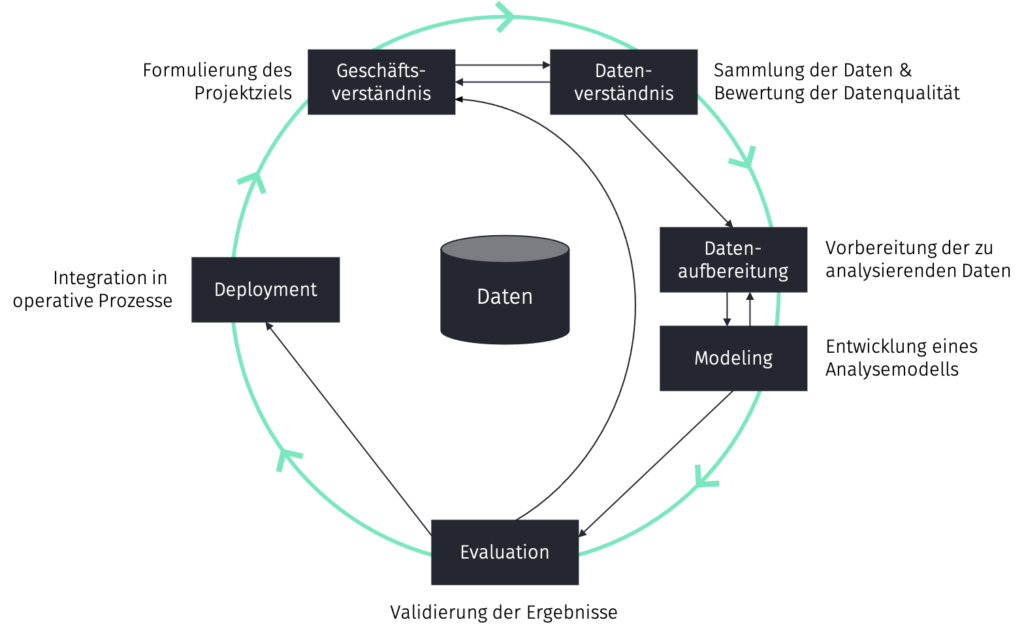

Egal ob Sie ein Data Science Projekt firmenintern umsetzen möchten oder ob Sie jemanden externen mit der Durchführung betrauen, ein Data Science Projekt folgt grundsätzlich bis auf kleinere Abwandlungen demselben Verlauf. Und zwar nach dem sogenannten Cross Industry Standard Process for Data Mining, kurz CRISP-DM. Der CRISP-DM Prozess ist eine standardisierte Vorgehensweise für Data Science Projekte, der fünf bis sechs iterative Prozessschritte umfasst.

Der sechsteilige CRISP-DM Prozess für erfolgreiche Data Science Projekte (Quelle: Westphalia DataLab in Anlehnung an Smart Vision Europe, Phases of the CRISP-DM reference model)

Schritt 1: Das Geschäftsverständnis

Welche Problemstellung und Fragen kommen im Unternehmen auf? Und können diese anhand von Daten beantwortet werden? In der ersten Phase gilt es herauszufinden, welches Problem die Mitarbeiter eines Unternehmens beschäftigen und ob und wie dieses Problem mit Daten gelöst werden kann. Ziel ist das Finden eines passenden Anwendungsfalls (Use Case), eine Bestandsaufnahme der aktuellen Prozesse und Infrastruktur und das Definieren klarer und messbarer Projektziele. Vor allem letzteres wird oft unterschätzt, ist aber zentral für die spätere Bestimmung des Projekterfolgs eines jeden Data Science Projekts.

Schritt 2: Das Datenverständnis

Welche Daten sind für die Erfüllung des Projektziels notwendig? Und wie liegen die Daten vor? Der Datenbestand bildet die Grundlage eines jeden Data Science Projekts. Ziel des zweiten Schrittes ist daher, sich einen Überblick über die zur Verfügung stehenden Daten zu verschaffen und die Qualität der Daten zu bewerten. Der Data Scientist prüft in diesem Schritt daher, ob die vom Unternehmen bereitgestellten Daten die Daten enthalten, die zur Erfüllung des Projektziels notwendig sind und ob es sich lohnt eventuell weitere Daten zu erheben.

Schritt 3: Die Datenaufbereitung

Wie lassen sich verschiedene Datensilos zusammenbringen? Welche Variablen eignen sich für eine Modellierung? Die Phase der Datenvorbereitung dient dazu, einen finalen Datensatz für die nachfolgende Analyse bereitzustellen. Dieser Schritt beansprucht oftmals die meiste Zeit eines Data Science Projekts. Es gilt die Daten aus oftmals unterschiedlichen Quellen in einen Analysedatensatz zu konsolidieren, die Daten zu bereinigen und neue, weitere Variablen aus den bereinigten Daten abzuleiten.

Schritt 4 und 5: Analyse und Evaluation

Welches Modell performed am besten? Sollte auf Deep Learning zurückgegriffen werden oder reichen einfache statistische Verfahren? Im Schritt der Analyse werden zur Problemstellung passende Analysemethoden ausgewählt und angewandt. Es gilt Modelle zu erstellen, welche das anfängliche Problem ausreichend akkurat modellieren. Deshalb kommt der Evaluation der Analyseergebnisse auch eine bedeutende Rolle zu. Diese Phase dient somit einer sogenannten Machbarkeitsstudie, zumeist unter dem englischen Begriff Proof of Concept (POC) bekannt. Idealerweise wird in diesem Schritt das Projektkonzept mit den eingangs definierten Erfolgsindikatoren bestätigt. Es kann sich aber auch herausstellen, dass Datenbasis oder -qualität für die Modellierung nicht ausreichen und man sich in eine frühere Phase des Projekts zurückbegeben muss.

Sofern die Analyseergebnisse einen operativen Mehrwert für Unternehmen und Anwender bestätigen, sollte eine systematische Operationalisierung, d.h. die Bereitstellung des Modells (Deployment) erfolgen. Hierzu wird eine individuelle Softwarelösung entwickelt, welche das zuvor erstellte Modell und die Analyseergebnisse dauerhaft in die IT-Infrastruktur und operativen Geschäftsprozesse des Unternehmens integriert.

Mit der Entscheidung zur Operationalisierung wird das Data Science Projekt in ein Softwareentwicklungsprojekt transferiert, welches zahlreiche neue Herausforderungen mit sich bringt: Entspricht der im POC behandelte statische Datensatz den realen zur Verfügung stehenden Daten? Verändern diese Daten sich mit der Zeit und hat das einen Einfluss auf die Performance des Models? Diese Fragen zum sogenannten Model Drift und Weitere gilt es während der Operationalisierung zu beantworten. Nichtsdestotrotz liegt in der Entwicklung eines solchen Datenprodukts der Schlüssel, um Daten langfristig gewinnbringend einzusetzen und den eigentlichen Mehrwert von Data Science Projekten zu erreichen.

Fazit

Egal welcher konkrete Anwendungsfall Ihnen vorschwebt, das beschriebene CRISP-DM Prozessmodell ist auf jedes beliebige Data Science Projekt anwendbar und bietet Ihnen somit einen wertvollen Orientierungsrahmen.

Sie wollen wissen, wie die einzelnen Schritte konkret angewandt auf einen QM Use Case aussehen? Dann schauen Sie in den kommenden Wochen weiter auf dem Blog vorbei: Mit der Serie „Predicting Quality mit KI“ beleuchten wir die einzelnen Schritte im Detail.

Auf der Homepage des Westphalia DataLab weitere Informationen zu diesem und weiteren spannenden Themen.